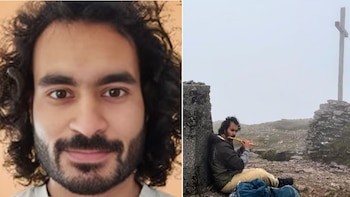

Mrinank Sharma, hasta el 9 de febrero responsable del área de salvaguardas de seguridad en inteligencia artificial en Anthropic, dejó la compañía tras dos años y advirtió en su carta de renuncia que “el mundo está en peligro”. Sharma sostiene que la situación actual va más allá de los desafíos de la inteligencia artificial y refleja una serie de crisis interconectadas que avanzan de manera simultánea.

Su mensaje subraya los dilemas éticos y la dificultad de actuar con integridad en un ámbito marcado por rápidos cambios.

“Hay tanto aquí que me inspira y me ha inspirado”, inicia Sharma en su mensaje dirigido a sus colegas. Destaca valores como la determinación, la brillantez intelectual y “la considerable amabilidad que impregna nuestra cultura”.

El investigador recuerda su llegada a San Francisco tras su doctorado con el propósito de aportar a la seguridad en inteligencia artificial. “He logrado lo que quería aquí”, asegura.

Entre los aportes que menciona figuran el análisis de la adulación de la inteligencia artificial y sus causas; el desarrollo de defensas para reducir los riesgos del bioterrorismo asistido por IA; la implementación de esas defensas; y la redacción de uno de los primeros casos de seguridad en IA.

Sharma señala como logros recientes su apoyo a la implantación de mecanismos de transparencia interna y un proyecto orientado a entender cómo los asistentes de inteligencia artificial pueden “hacernos menos humanos o distorsionar nuestra humanidad”.

Reconoce la dificultad de que los valores personales dirijan las acciones diarias. “He visto repetidamente lo difícil que es realmente dejar que nuestros valores rijan nuestras acciones”, escribe, remarcando que estas presiones han estado presentes tanto en la organización como en la sociedad.

Advierte que elegir el camino correcto a menudo implica tomar decisiones difíciles y dejar de lado lo que más importa.

Su advertencia es clara: “El mundo está en peligro. Y no solo por la inteligencia artificial o las armas biológicas, sino por una serie de crisis interconectadas que se desarrollan en este mismo momento”.

En su carta sostiene la urgencia de enfrentar los riesgos que traen estos cambios concatenados para minimizar el peligro global.

La decisión de Sharma refleja también una búsqueda de integridad personal y nuevas formas de contribuir.

“Quiero aportar de una manera que sienta plenamente alineada con mi integridad y que me permita expresar mis particularidades”, expone.

Influido por referentes literarios, expresa: “Quiero explorar las preguntas que siento realmente esenciales, esas dudas que, como diría David Whyte, ‘no tienen derecho a irse’, o que Rilke nos insta a ‘vivir’”.

“No sé qué viene ahora”, admite al referirse a sus planes inmediatos. Su objetivo es “crear un espacio para dejar a un lado las estructuras que me han sostenido estos años y ver qué emerge en su ausencia”.

Informa que regresará al Reino Unido para dedicarse a la escritura, la exploración literaria y el trabajo comunitario, incluyendo la intención de estudiar poesía y reforzar su implicación en tareas de facilitación y construcción comunitaria.

La carta de Sharma coincide con otras salidas recientes en Anthropic y un clima de atención especial sobre la ética y la seguridad en el desarrollo de inteligencia artificial.

La empresa, fundada por antiguos integrantes de OpenAI, ha promovido una imagen centrada en la seguridad y ha establecido mecanismos para encarar riesgos, como el bioterrorismo y la potencial pérdida de humanidad ante el avance tecnológico.

El CEO de Anthropic, Dario Amodei, también ha hecho advertencias públicas sobre los peligros de desarrollar tecnología sin un marco ético sólido.

Para Sharma, el desafío es que la sabiduría de la humanidad crezca al mismo ritmo que su poder de transformación. Al despedirse, insta a no perder de vista ese equilibrio ante los riesgos que se avecinan.

A pesar de las advertencias expresadas por Sharma y el debate ético que atraviesa la industria, la inteligencia artificial sigue impulsando transformaciones profundas en áreas como la salud, la educación y la investigación científica.

Diversos especialistas y referentes del sector sostienen que, con marcos regulatorios adecuados y la participación activa de la comunidad científica, estas tecnologías pueden contribuir a resolver problemas complejos y mejorar la calidad de vida a escala global.

El debate sobre los límites y la responsabilidad en su desarrollo, reactivado por episodios como la renuncia de Sharma, podría fortalecer las salvaguardas y la supervisión en la industria tecnológica.

Últimas Noticias

Así puedes acelerar un celular Android que funciona lento en cinco pasos

Reiniciar el teléfono con regularidad, gestionar de forma eficiente el almacenamiento y actualizar el sistema operativo y las aplicaciones son algunas de las medidas a tomar

Todo sobre las passkeys: le método de seguridad que pueda acabar con las contraseñas

Este sistema tiene una alta protección al phishing porque la clave privada nunca se comparte con los servicios o sitios web

Cuentas inactivas y servidores olvidados: la “bodega” digital que está abriendo la puerta a los hackers

Servidores, cuentas y aplicaciones inactivas multiplican la superficie de ataque y exponen a las empresas a vulnerabilidades críticas, incumplimientos legales y costos innecesarios

Guía para saber qué responder y qué no si llama un número desconocido

Autoridades internacionales alertan sobre sofisticadas estafas que manipulan datos privados para convencer a las víctimas y obtener respuestas comprometedoras que faciliten robos

Flappy Bird: el juego que generaba 50 mil dólares al día, pero su creador lo eliminó porque no lo dejaba dormir

El sencillo diseño y su alta dificultad lo convirtieron en un éxito viral hace una década entre millones de jugadores de todo el mundo