La inteligencia artificial generativa abrió un nuevo frente en el delito digital: la sextorsión basada en imágenes falsas creadas a partir de fotos reales. En 2025, investigadores de ciberseguridad detectaron varias bases de datos abiertas, sin protección ni cifrado, que almacenaban más de un millón de imágenes y videos generados por herramientas de IA.

Gran parte del material era de carácter sexual y, en algunos casos, se habría creado utilizando fotografías reales obtenidas de redes sociales, lo que expuso a cualquier persona a convertirse en víctima de chantaje sin haber compartido contenido íntimo.

El hallazgo encendió alertas sobre la falta de controles de privacidad en algunos servicios de IA y el impacto directo que esto tiene en la seguridad digital. A diferencia de años anteriores, cuando la sextorsión estaba asociada principalmente al intercambio voluntario de imágenes privadas, hoy basta con tener una foto pública en internet para ser blanco de este tipo de extorsión.

Qué es la sextorsión digital

La sextorsión digital es una modalidad de chantaje donde delincuentes utilizan herramientas de inteligencia artificial para generar desnudos falsos (deepfakes) a partir de una foto común de redes sociales. A diferencia de la sextorsión tradicional, la víctima nunca se tomó una foto íntima, pero el atacante amenaza con difundir el montaje si no se realiza un pago.

La inteligencia artificial modificó por completo este esquema. Con herramientas de generación de imágenes, hoy es posible crear desnudos falsos o escenas comprometedoras de manera rápida y convincente, sin necesidad de conocimientos técnicos avanzados. En minutos, una foto común puede transformarse en contenido sexualizado, listo para ser utilizado como herramienta de chantaje.

Bases de datos expuestas y servicios involucrados

En octubre de 2025, el investigador Jeremiah Fowler descubrió una base de datos de acceso público que contenía más de un millón de archivos generados por IA, la mayoría de contenido pornográfico. El material no estaba protegido y podía ser descargado por cualquier persona.

El análisis técnico vinculó la filtración con herramientas de terceros como MagicEdit y DreamPal, servicios que permitían editar imágenes, intercambiar rostros y generar contenido explícito a partir de descripciones de texto o fotos cargadas por los usuarios.

Aunque estas plataformas se presentaban como espacios de experimentación creativa, parte de sus funciones facilitaba la creación de imágenes sexualizadas. Tras la denuncia, ambos servicios suspendieron operaciones y sus aplicaciones fueron retiradas de tiendas oficiales.

Investigaciones posteriores revelaron otras bases de datos abiertas, algunas con decenas de miles de imágenes, incluidas representaciones sexualizadas de personas que aparentaban ser menores, lo que elevó aún más la gravedad del problema.

Un riesgo que ya no distingue perfiles

Uno de los puntos más preocupantes es que la sextorsión con IA ya no se limita a figuras públicas o personas con exposición mediática. Cualquier usuario con fotografías visibles en redes sociales puede ser afectado. Mujeres y adolescentes son los grupos más vulnerables, aunque los expertos advierten que nadie está completamente a salvo.

Además del daño económico, las víctimas enfrentan consecuencias emocionales, reputacionales y psicológicas, incluso cuando las imágenes son falsas.

Consejos para víctimas y prevención

Ante este escenario, especialistas en ciberseguridad recomiendan una combinación de prevención, reacción rápida y apoyo:

- No ceder al chantaje: pagar o acceder a exigencias no garantiza que el material no sea difundido.

- Guardar evidencia: conservar mensajes, correos y enlaces utilizados por el extorsionador.

- Denunciar: reportar el caso a la plataforma involucrada y a las autoridades locales.

- Revisar la privacidad: limitar el acceso público a fotos personales en redes sociales.

- Pedir apoyo: buscar ayuda psicológica y legal, especialmente en casos que involucren menores.

En la era de la inteligencia artificial, la protección de la identidad digital se volvió una necesidad básica. La sextorsión ya no depende de errores individuales, sino de un ecosistema tecnológico que avanza más rápido que sus mecanismos de control. La información, la prevención y la denuncia siguen siendo las principales herramientas para enfrentar esta nueva realidad.

Últimas Noticias

Diseño ultracompacto y alerta inmediata: así funciona el innovador sensor que permite detectar lesiones cerebrales en tiempo real

El dispositivo, concebido para integrarse fácilmente en cascos y equipos de protección, emite señales automáticas ante golpes peligrosos y ofrece una solución eficiente para la prevención temprana de daños cerebrales en deportes y entornos laborales

Internet Starlink de Elon Musk en los vuelos: conectividad imprescindible o gasto excesivo

Las aerolíneas deben evaluar el impacto de incorporar servicios de internet satelital en sus operaciones y en la experiencia de los pasajeros

Spotify o WhatsApp: la nueva función de grupos para chatear y escuchar música al mismo tiempo

La plataforma musical ha incorporado una función que permite a los usuarios crear grupos con un máximo de 10 integrantes

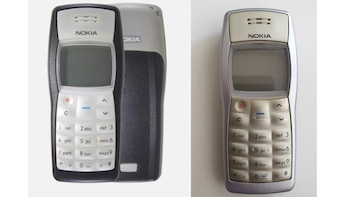

Nokia 1100 vs. Nokia 1101: cuáles son las diferencias de estos celulares retro famosos por sus ventas

El Nokia 1100 logró ser el celular más vendido de todos los tiempos, alcanzando 250 millones de unidades vendidas

Cómo ver películas y series gratis tras el bloqueo de Magis TV en Fire TV

A raíz de esta medida, miles de usuarios de dispositivos Amazon quedaron sin acceso a contenido gratuito