Instagram y Facebook han anunciado nuevos límites a lo que los adolescentes pueden ver en sus aplicaciones, una medida que, según Meta, su empresa matriz, reducirá la cantidad de contenidos potencialmente nocivos que encuentran los jóvenes.

Los adolescentes ya podían optar por que el algoritmo de Instagram recomendara menos “contenido sensible”, que incluye cuerpos desnudos, violencia, drogas, armas de fuego, pérdida de peso y discusiones sobre autolesiones. Ahora, Meta dice que ocultará el contenido sensible incluso si lo publican amigos o creadores a los que siguen los adolescentes.

El cambio se produce semanas antes de que Mark Zuckerberg, consejero delegado de Meta, testifique ante el Comité Judicial del Senado sobre lo que los legisladores han calificado de “fracaso de la empresa a la hora de proteger a los niños en Internet”. En la sesión del 31 de enero de 2024, Zuckerberg, junto con ejecutivos de las aplicaciones sociales TikTok, Snap, Discord y X, responderán a preocupaciones sobre la seguridad en línea, como la publicidad depredadora, el acoso y las publicaciones que promueven una alimentación desordenada.

Las empresas tecnológicas también se enfrentan a un creciente escrutinio por parte de las autoridades estatales y extranjeras. En los últimos años, los estados han aprobado una serie de leyes de seguridad infantil en línea, algunas de las cuales exigen que las plataformas obtengan el consentimiento de los padres antes de permitir que los usuarios adolescentes creen cuentas.

De ser efectivos, los últimos cambios de Meta supondrían menos menciones a temas como las dietas o las enfermedades mentales en los timelines de los adolescentes. Pero sin datos internos de Meta, que la empresa no suele compartir, no está claro hasta qué punto estos límites protegen a los adolescentes de contenidos nocivos. Además, aunque las cuentas de adolescentes tienen activado por defecto el filtro de contenido sensible, pueden crear cuentas nuevas fácilmente y no tienen que revelar su verdadera edad.

Según Josh Golin, director ejecutivo de Fairplay, una organización sin ánimo de lucro cuyo objetivo es acabar con el marketing dirigido a los niños. Meta se opone continuamente a las normas de seguridad y no aplica controles significativos. A finales de 2022, por ejemplo, un grupo del sector financiado por Meta presentó una demanda para bloquear una ley de seguridad infantil en California.

“Si Meta se tomara realmente en serio la seguridad, se apartaría del camino de la regulación”, dijo Golin. “Han tenido más de una década para hacer que su plataforma sea más segura para los jóvenes, y han fracasado estrepitosamente”.

“Nuestro trabajo sobre la seguridad de los adolescentes se remonta a 2009, y estamos continuamente construyendo nuevas protecciones para mantener a los adolescentes seguros y consultando con expertos para asegurar que nuestras políticas y características están en el lugar correcto”, dijo la portavoz de Meta, Liza Crenshaw. “Estas actualizaciones son el resultado de ese compromiso y consulta continuos y no responden a ningún acontecimiento en particular”.

No es la primera vez que Meta lanza funciones de seguridad antes de una comparecencia ante el Congreso. En 2021, la empresa lanzó avisos opcionales de “pausa”, que sugieren a los usuarios dejar de desplazarse temporalmente, el día antes de que el jefe de Instagram, Adam Mosseri, testificara ante el Congreso.

Semanas antes, la exempleada de Facebook Frances Haugen había filtrado una investigación interna que mostraba que la empresa sabía que sus productos a veces empeoraban los problemas de imagen corporal de algunas adolescentes. La empresa defendió su historial de seguridad y rebatió las caracterizaciones de los estudios, pero ha seguido sufriendo presiones en Washington para ampliar la protección de los menores.

A finales del año pasado, la empresa pidió por primera vez públicamente una ley federal que obligue a las tiendas de aplicaciones a obtener la aprobación de los padres cuando los usuarios de entre 13 y 15 años descarguen aplicaciones.

California, por su parte, aprobó en 2022 otra ley que obliga a las empresas a aplicar por defecto parámetros de privacidad y seguridad más estrictos para los niños, conocida como Código de Diseño Adecuado a la Edad de California. La medida californiana sigue el modelo de una normativa similar británica.

Instagram y Facebook colocarán automáticamente todas las cuentas de adolescentes en la configuración de contenido sensible más restrictiva. La aplicación también está ampliando sus términos de búsqueda bloqueados relacionados con el suicidio, las autolesiones y los trastornos alimentarios, según informa la empresa. Si alguien busca “bulímico”, por ejemplo, verá recursos de ayuda para trastornos alimentarios en lugar de resultados de búsqueda.

Meta ha tenido problemas para definir con precisión qué contenidos se consideran sensibles. Por ejemplo, el control de contenido sensible oculta a los usuarios menores de 15 años las publicaciones “sexualmente sugerentes”. Pero la decisión de si una foto de una persona en bikini se considera “sexualmente sugerente” depende de la tecnología de escaneado de la aplicación, y Crenshaw no quiso mencionar sus criterios.

Algunos defensores de la seguridad de los jóvenes afirman que el enfoque poco sistemático de Meta tiene más que ver con las relaciones públicas que con la protección de los jóvenes.

Kristin Bride, una madre de Arizona que trabaja con la organización bipartidista Issue One para defender la ley federal Kids Online Safety Act, señala que los cambios en el control de contenidos de las empresas de redes sociales suelen ser “menores, temporales y de boquilla”. Aún así, dice, “cualquier cambio que Meta haga en sus plataformas para hacerlas más seguras para los niños es apreciado, especialmente por los padres.”

Algunos expertos en seguridad han pedido a la empresa que haga públicos sus algoritmos y sus investigaciones internas para someterlos a auditoría. Otros se han preguntado por qué Meta permite a los menores acceder a sus aplicaciones si no puede garantizar que no se vean arrastrados por laberintos algorítmicos que promueven la autolesión, los trastornos alimentarios o el extremismo político.

Al mismo tiempo, algunos estudios demuestran que las redes sociales pueden ser buenas para los jóvenes. Los amigos en línea pueden ser un elemento disuasorio contra el suicidio, y los adolescentes LGBTQ a menudo encuentran comunidad y apoyo en las redes sociales cuando no lo tienen en casa.

(c) 2024, The Washington Post

Últimas Noticias

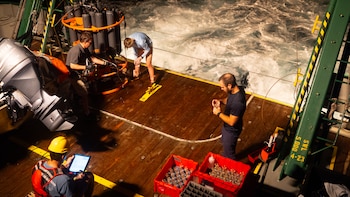

Por qué los cambios en una corriente oceánica de Florida podrían causar estragos a nivel mundial

Es parte del escenario de “El día después de mañana”, pero los científicos discrepan sobre si ocurrirá o sobre la rapidez con la que podría ocurrir. Un equipo que estudia la corriente actual se esfuerza por arrojar luz sobre el tema

La CIA y el Pentágono investigaron un dispositivo secreto relacionado con el “síndrome de La Habana” en Noruega

En 2024, un investigador noruego escéptico sobre la capacidad de las armas de energía pulsada para dañar el cerebro humano construyó un dispositivo y lo probó en sí mismo. No salió bien

El ejército de Estados Unidos completó la transferencia de más de 6 mil detenidos del Estado Islámico a Irak

Las autoridades estadounidenses han finalizado el traslado de los sospechosos del grupo extremista desde Siria al gobierno de Bagdad, lo que allana el camino para la retirada de soldados estadounidenses en los próximos meses

El Departamento de Seguridad Nacional de Estados Unidos enfrenta cierre inminente por la falta de acuerdo en el Congreso

Grandes áreas del Departamento de Seguridad Nacional cerrarán el sábado a menos que los legisladores y la Casa Blanca lleguen a un acuerdo de último minuto

Estos pacientes vieron lo que viene después de la muerte: ¿debemos creerles?

Los investigadores han desarrollado un modelo para explicar la ciencia de las experiencias cercanas a la muerte. Otros los han cuestionado