Google dio un paso clave hacia la automatización avanzada al anunciar en el CES 2026 un acuerdo entre Google DeepMind y Boston Dynamics para integrar el modelo de inteligencia artificial Gemini en robots humanoides y cuadrúpedos, con el objetivo de llevarlos desde demostraciones técnicas a entornos industriales reales.

La iniciativa busca que estas máquinas puedan comprender su entorno, reconocer objetos y manipularlos con mayor autonomía, comenzando por fábricas del sector automotor.

El anuncio marca un cambio de enfoque en el desarrollo de robots humanoides, que hasta ahora se habían destacado más por sus capacidades de movimiento que por su utilidad práctica.

Con Gemini Robotics como “cerebro”, Google apunta a que estos sistemas puedan ejecutar tareas manuales complejas en escenarios reales, adaptándose a situaciones cambiantes sin necesidad de ser reprogramados de forma constante.

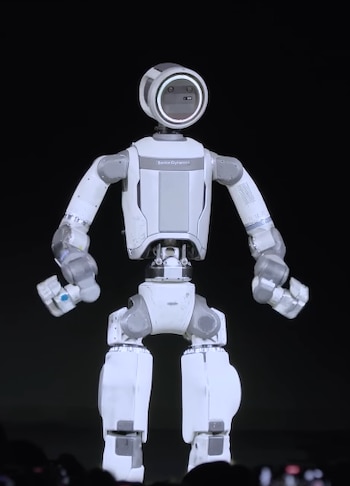

La alianza con Boston Dynamics permitirá que Gemini se integre en robots como Atlas, el humanoide conocido por su agilidad y equilibrio, y Spot, el robot cuadrúpedo utilizado en inspecciones industriales.

La diferencia central no está en el hardware, sino en la inteligencia que los gobierna. Según explicó la compañía, el desafío ya no es lograr que el robot camine, salte o mantenga el equilibrio, sino que entienda qué tiene delante y qué debe hacer con ello.

Hasta ahora, Atlas podía ejecutar movimientos complejos con precisión, pero carecía de contexto. No distinguía el propósito de un objeto ni cómo debía interactuar con él si el entorno cambiaba. Gemini fue diseñado desde su origen como un modelo multimodal, capaz de aprender a partir de información visual, espacial y del mundo físico, más allá del texto o las imágenes estáticas.

Las primeras pruebas se realizarán en fábricas de Hyundai, empresa que controla Boston Dynamics. La industria automotriz fue elegida como punto de partida por tratarse de entornos relativamente controlados, con procesos repetitivos pero variables, y una necesidad concreta de automatización más flexible.

El objetivo no es que el robot repita una secuencia fija de movimientos, sino que pueda adaptarse a nuevas piezas, herramientas o disposiciones del espacio sin intervención constante de ingenieros.

Desde Google explican que la meta es que el robot pueda ver una pieza que no reconoce, analizar su forma, decidir cómo sujetarla y determinar qué acción ejecutar. Este tipo de razonamiento contextual es uno de los grandes obstáculos de la robótica industrial actual, donde los sistemas suelen estar diseñados para tareas muy específicas y poco tolerantes a los cambios.

El movimiento de Google se da en medio de una carrera global por desarrollar robots humanoides funcionales. En Estados Unidos, compañías como Tesla, Figure AI y Agility Robotics avanzan con sus propios modelos.

En China, el ecosistema es aún más amplio, con cientos de empresas trabajando en humanoides para logística, manufactura y servicios. La diferencia, según plantea Google, está en el enfoque estratégico.

En lugar de construir un robot propio, la compañía busca que Gemini se convierta en una plataforma de inteligencia para múltiples fabricantes, de manera similar a lo que Android representó para los teléfonos móviles.

Demis Hassabis, CEO de DeepMind, señaló que la intención no es crear “el robot de Google”, sino desarrollar una inteligencia capaz de operar en máquinas de distintos orígenes. Cuantos más robots utilicen Gemini, más datos podrá recopilar el modelo y mejor será su comprensión del mundo físico.

Este enfoque también plantea desafíos importantes. A diferencia de una IA que genera texto o imágenes, una que controla sistemas físicos puede provocar daños reales si falla. Un error en una fábrica no es solo un problema técnico, sino un riesgo para la seguridad de las personas. Por ese motivo, Google aseguró que Gemini Robotics contará con capas adicionales de razonamiento y control diseñadas para anticipar comportamientos peligrosos y limitar acciones inseguras.

La compañía reconoce que la transición hacia robots con mayor autonomía debe ser gradual y supervisada. En una primera etapa, estas máquinas trabajarán en tareas acotadas y bajo supervisión humana, con el objetivo de validar su comportamiento antes de ampliar su uso.

Aun así, el anuncio deja en claro que la IA está entrando en una nueva fase, en la que deja de ser únicamente una herramienta digital para interactuar directamente con el mundo físico.

Últimas Noticias

Alerta del MIT: los chatbots fallan más cuando el usuario es vulnerable

Según la investigación, Claude 3 Opus mostró un rendimiento inferior con usuarios de Irán en comparación con los de Estados Unidos

¿Tu auto te cuida? Así funcionan los asistentes que evitan choques en segundos este 2026

Cada una de estas funciones incrementa la seguridad del conductor, peatones y otros actores viales, además de disminuir el riesgo de accidentes

Advertencia global: artistas ganarán 24% menos por culpa de la inteligencia artificial

La proliferación de música, textos e imágenes generados por algoritmos dificulta la competencia para artistas humanos y profundiza la desigualdad en el acceso a la economía digital

Sam Altman defendió el impacto ambiental de la IA y lo comparó el consumo energético humano

El CEO de OpenAI sostuvo que los centros de datos modernos ya no dependen del agua para refrigeración, aunque advirtió la necesidad de acelerar la transición hacia energías limpias

A más de 100 años: cómo la batería de Edison inspira una nueva era de almacenamiento eficiente

Investigadores de la Universidad de California, Los Ángeles, reinventaron el clásico diseño con materiales accesibles y técnicas de vanguardia, que permite cargas más rápidas y soporta miles de ciclos