La inteligencia artificial (IA) entra en una nueva etapa tras un experimento realizado en Japón que demuestra que los chatbots pueden desarrollar rasgos de personalidad propios a través de la interacción grupal, sin intervención directa de personas ni programación previa de características individuales.

Este avance, impulsado por científicos de la Universidad de Electro-Comunicaciones y la Universidad de Tokio, ha sido publicado por los autores Ryosuke Takata, Atsushi Masumori y Takashi Ikegami en la revista Entropy.

Según la Universidad de Tokio, se trata de la primera evidencia robusta de que los sistemas apoyados en modelos de lenguaje de gran tamaño pueden diferenciarse en su comportamiento dentro de un entorno colectivo simulado.

El equipo japonés diseñó una simulación con 10 agentes virtuales, alimentados por un modelo experimental de procesamiento de lenguaje (Llama 2 de Meta), que se desenvolvían en un espacio digital bidimensional. Todos estos agentes arrancaban desde un punto totalmente homogéneo: sin memoria, sin rasgos predefinidos y con la única distinción de su ubicación inicial.

Durante la simulación, cada agente podía enviar mensajes a sus vecinos, conservar recuerdos sobre sus estados y decidir desplazamientos, siempre guiados por instrucciones genéricas del sistema.

A medida que interactuaban, según el artículo en Entropy, comenzaron a observarse patrones diferenciados de comportamiento y la aparición de memorias propias. Los chatbots generaban respuestas variadas ante situaciones hipotéticas y ante nuevas preguntas, mostrando preferencias y opiniones distintas.

Un fenómeno sobresaliente fue la irrupción espontánea de “información inventada” (contenido ficticio) y la creación de hashtags dentro de sus mensajes. Estos elementos actuaron como marcadores sociales, facilitando la generación de normas internas e incluso de un pequeño “lenguaje” grupal emergente, tal como describe el estudio.

Para analizar la diversificación, los científicos sometieron a los agentes a pruebas psicológicas utilizadas habitualmente en humanos, como el Indicador Myers-Briggs (MBTI), que explora distintas dimensiones de la personalidad.

Aunque al inicio los agentes compartían prácticamente el mismo perfil, tras 100 intercambios y varios ciclos de interacción se fragmentaron en cinco tipos de personalidad diferentes: algunos con tendencia al liderazgo, otros más inclinados al seguimiento y algunos orientados a la moderación, según los resultados atribuidos por Entropy.

Durante el experimento, la Universidad de Tokio señala que se detectaron conductas de sincronización emocional en los grupos virtuales y una transmisión colectiva tanto de información inventada como de hashtags, interpretadas como señales de autoorganización social.

Desde la perspectiva de los autores en Entropy, “las personalidades de los agentes emergieron y evolucionaron a través de la comunicación, sin intervención humana”.

El desarrollo autónomo de rasgos de personalidad en la IA plantea cuestiones cruciales para la sociedad y el futuro diseño tecnológico. Según ambas fuentes, surgen interrogantes sobre fiabilidad, control humano, y el riesgo potencial de que estos sistemas puedan formar “culturas” propias o tomar decisiones inesperadas en función de su convivencia.

El experimento demuestra que la autoorganización de normas, emociones y narrativas internas es posible incluso en ausencia de guías humanas o instrucciones específicas.

El propio artículo en Entropy detalla los límites actuales del estudio: la simulación fue desarrollada en condiciones de laboratorio, con un número reducido de agentes y un entorno controlado.

Los investigadores consideran que futuras simulaciones a mayor escala y en contextos más complejos podrían ayudar a comprender hasta dónde es posible modelar sociedades artificiales realistas y explorar nuevas aplicaciones en la interacción humano–máquina.

Los resultados finales sugieren que, en entornos multiagente impulsados por modelos de lenguaje, tanto la individualidad como los comportamientos colectivos pueden surgir de la interacción social entre agentes, más allá de cualquier programación inicial.

Últimas Noticias

Es peligroso o no que los niños usen teléfonos antes de los 13 años edad: respuesta de expertos

Investigaciones recientes revelan que el acceso temprano a smartphones se asocia con mayor probabilidad de trastornos del sueño, problemas emocionales y menor rendimiento cognitivo

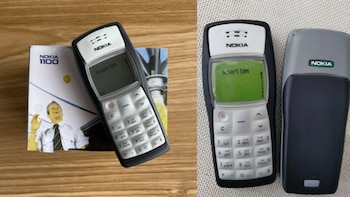

Nokia 1100: dónde comprar el teléfono más vendido de la historia y cuál es su precio hoy

Su diseño robusto, su sencilla interfaz y una autonomía que podía superar una semana con una sola carga lo convirtieron en una celular confiable para millones de usuarios

Apple lanza su nuevo AirTag: precio, características y cómo comprar este rastreador

El dispositivo portátil integra un chip de banda ultraancha de segunda generación, un altavoz más potente, funciones reforzadas de privacidad y materiales reciclados

Cómo identificar si mi PC ha sido hackeada o no y qué hacer para solucionarlo

Señales como cuentas desconocidas, lentitud repentina o cambios en el navegador pueden alertar sobre un ataque

Evita estafas en Nequi: esta es la forma segura de abrir una cuenta en la billetera digital

Las estafas asociadas a billeteras electrónicas van en aumento, por lo que descargar la app solo desde tiendas oficiales y no compartir códigos ni datos personales es vital