La acelerada expansión de la inteligencia artificial generativa está generando una amenaza subestimada, la exposición de datos personales y laborales que los usuarios comparten en los chats de estas plataformas. Expertos en tecnología y ciberseguridad advierten que la mayoría de los servicios gratuitos o personales utilizan por defecto la información introducida por las personas para continuar entrenando sus modelos, salvo que el usuario modifique manualmente la configuración.

Según estimaciones de mercado citadas recientemente por consultoras internacionales, herramientas como ChatGPT superan los cientos de millones de usuarios semanales, lo que multiplica la escala de información sensible que circula a través de estos canales.

Los especialistas indican que el riesgo no se concentra en que la IA “cuente secretos” de forma literal, sino en que ciertos textos únicos podrían quedar almacenados en la memoria de entrenamiento, habilitando la posibilidad de que fragmentos excepcionales reaparezcan ante consultas de terceros.

El fenómeno se intensifica en entornos laborales. Investigaciones recientes revelan que una parte significativa de los trabajadores utiliza modelos no aprobados por sus organizaciones para resolver tareas cotidianas. Esto incluye actividades como resumir documentos, crear contenido informativo o analizar datos.

De acuerdo con informes privados citados en el sector, más de dos tercios de los empleados comparte información interna o documentos de trabajo dentro de chats públicos de IA. Esa conducta amplifica el riesgo de filtraciones no intencionales, incumplimientos contractuales y eventuales sanciones regulatorias.

Los expertos coinciden en que el error más común consiste en copiar archivos enteros —incluyendo listas de salarios, contratos, estrategias de marketing o código propietario— hacia interfaces que no garantizan privacidad ni retención controlada.

¿Qué versiones de IA utilizan la información del usuario?

El comportamiento respecto al uso de datos varía según el plan contratado. En los servicios personales o gratuitos, las compañías suelen habilitar por defecto la utilización de las conversaciones para mejorar el modelo. En cambio, los planes corporativos —generalmente pagos— incluyen acuerdos específicos que excluyen el contenido del entrenamiento.

De acuerdo con especialistas en arquitectura de datos, estos criterios se encuentran documentados en términos de uso, políticas de privacidad y secciones como “nuestro uso del contenido”. Es en estos apartados donde se detalla si la información ingresada puede ser empleada para desarrollar o optimizar el servicio.

En líneas generales, la dinámica es la siguiente: las versiones gratuitas o personales de ChatGPT, Gemini, Copilot o Claude utilizan por defecto el material de los usuarios para entrenamiento; mientras que los planes empresariales, académicos o gubernamentales excluyen esta práctica y ofrecen retención controlada, auditoría y acuerdos formales.

¿Qué no se debe introducir nunca en un chat de IA?

Para quienes no utilizan versiones de nivel corporativo, el consejo es concreto, no introducir datos de identificación personal, información financiera, credenciales de acceso, números de tarjetas o información especialmente sensible (salud, biometría o creencias). Tampoco se recomienda compartir contenido relativo a operaciones internas de una empresa, precios internos o material que aún no haya sido anunciado públicamente.

Otra recomendación frecuente del sector consiste en establecer protocolos internos antes de habilitar el uso de IA generativa en equipos de trabajo. Estas políticas suelen incluir restricciones sobre la naturaleza del contenido permitido y mecanismos internos de aprobación previa.

Lo que debes revisar antes de empezar a usar una IA

La adopción del modelo gratuito de IA para tareas rápidas seguirá siendo elevada. Sin embargo, los especialistas destacan que la supervisión debe desplazarse hacia el uso responsable. Revisar los apartados de privacidad, desactivar la utilización de datos cuando sea posible y no compartir información crítica son medidas que reducen de forma sustancial el riesgo.

Las plataformas seguirán ampliando su presencia, pero la gestión de los datos que un usuario introduce será determinante para evitar filtraciones involuntarias.

Últimas Noticias

Cómo es la nueva IA de Google que resuelve problemas científicos

El modelo Gemini 3 Deep Think utiliza un sistema de razonamiento que evalúa y descarta rutas lógicas inconsistentes antes de responder

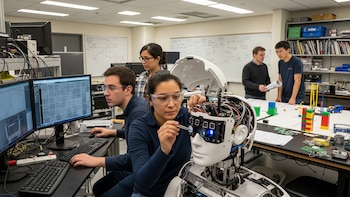

Desarrollan sensor que les da a los robots una visión de 180 grados y olfato artificial

El dispositivo, inspirado en la biología de la mosca de la fruta, amplía la autonomía y eficacia de las máquinas

Cómo Google apuesta todo para dominar la infraestructura de la inteligencia artificial

La empresa matriz Alphabet lanzó una emisión récord de deuda a 100 años para financiar el mayor salto de capacidad en su historia: busca duplicar su infraestructura de inteligencia artificial, apostando a liderar el control de los chips y los centros de datos

Los usuarios de YouTube Music ahora podrán usar IA para generar listas de reproducción

Solo los usuarios Premium en iOS y Android pueden acceder a las ‘playlists’ creadas por inteligencia artificial

Un año de Amazon Prime: estas son las cifras de comercio electrónico en Colombia

Artículos para el hogar, ropa, tecnología y belleza fueron las categorías más elegidas por los miembros Prime en el país sudamericano