El emprendedor argentino Alan Daitch, con más de dos décadas desarrollando startups digitales y enfocado en sistemas basados en inteligencia artificial, asegura que “cuando eres amable con la IA, ella genera respuestas más largas, mejor pensadas y más precisas”.

Según el experto, no se trata de una cuestión de urbanidad gratuita, sino de una estrategia para obtener mejores resultados técnicos. Esta visión está respaldada por investigaciones recientes que estudian cómo los grandes modelos de lenguaje, como ChatGPT, responden de manera diferente según el tono de las indicaciones que reciben.

Qué dice la ciencia sobre la cortesía con la IA

Investigadores de la Universidad de Cornell llevaron a cabo un estudio que analizó cómo estos sistemas reaccionan a distintas formas de comunicación. El resultado fue contundente: los comandos groseros o demasiado directos suelen producir respuestas de menor calidad, más propensas a errores u omisiones importantes.

En cambio, las solicitudes respetuosas —aquellas que contienen fórmulas como “por favor”, “¿podrías?”, o expresan un tono colaborativo— superan de forma sistemática a las interacciones bruscas, especialmente en tareas complejas como resúmenes, traducciones o explicaciones detalladas.

En algunos modelos, la diferencia en el rendimiento ante una petición educada frente a una impaciente puede llegar hasta un 30% menos de efectividad. Esto ocurre, según los investigadores, porque la inteligencia artificial ha sido entrenada con millones de ejemplos de lenguaje humano, muchos de ellos cargados de convenciones culturales.

De esta manera, el sistema aprende a replicar estructuras que reconoce como propias de una conversación colaborativa, y por tanto, responde en consecuencia.

La observación de Daitch se alinea con este enfoque. “La actitud con la que nos dirigimos a la inteligencia artificial influye, y mucho, en el tipo de respuesta que recibimos”, sostiene.

Y añade que esta práctica, más allá de la mejora funcional, puede contribuir al desarrollo de habilidades comunicacionales valiosas, como la empatía y la claridad en el lenguaje. En entornos laborales, donde el uso de IA comienza a ser habitual, este tipo de hábitos puede convertirse en un diferencial profesional.

Cuáles son las implicaciones éticas y ambientales de la cortesía

Más allá del rendimiento técnico y las implicancias en el plano interpersonal, existe un aspecto menos visible pero cada vez más relevante: el impacto ambiental. Cada interacción con sistemas como ChatGPT requiere procesamiento computacional intensivo.

Estos procesos consumen electricidad y agua —esta última utilizada para enfriar los servidores—, y su escala global multiplica rápidamente estos consumos.

Según la Agencia Internacional de la Energía, una sola consulta a ChatGPT puede requerir hasta diez veces más energía que una búsqueda convencional en Google. De forma más precisa, datos difundidos por Tom’s Hardware estiman que una solicitud promedio al modelo consume 0,3 vatios-hora de electricidad.

Aunque esto pueda parecer menor en términos individuales, cuando se replica por millones de usuarios al día, el impacto es considerable.

Un estudio de la Universidad de California complementa esta visión: incluso una respuesta breve de dos o tres palabras puede implicar un consumo de entre 40 y 50 mililitros de agua, utilizada para la refrigeración de los servidores. Así, expresiones como “gracias” o “por favor”, si bien mínimas desde el punto de vista lingüístico, agrandan la cadena de procesamiento y, por ende, la huella ecológica.

Qué dice Sam Altman sobre la amabilidad con ChatGPT

Esta tensión entre la cortesía lingüística y el uso eficiente de recursos fue abordada públicamente por Sam Altman, CEO de OpenAI, empresa responsable de ChatGPT. En una interacción en la red social X, un usuario le preguntó si las fórmulas educadas en las consultas tenían un impacto en los costos de operación.

Altman respondió con tono irónico: “Decenas de millones de dólares bien gastados”, haciendo referencia al incremento de palabras procesadas por los modelos debido a la cortesía de los usuarios.

Aunque la respuesta fue en clave de humor, revela una preocupación real. Cuanto más larga es la entrada textual de una consulta, mayor es el número de tokens y más complejas y costosas se vuelven las operaciones que ejecuta la IA.

Esta complejidad adicional requiere más tiempo de cálculo, un mayor uso de GPU (unidades de procesamiento gráfico) y un aumento en el consumo energético global del sistema.

Por este motivo, Altman y otros expertos plantean que si bien la cortesía puede tener beneficios en la calidad de las respuestas, conviene reservarla para situaciones donde realmente se la necesite, y evitar el uso indiscriminado de frases que extiendan innecesariamente las consultas.

Últimas Noticias

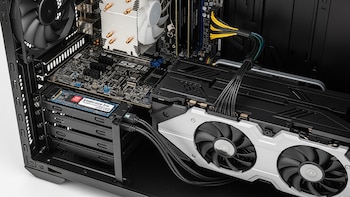

Su vecino le regaló una PC que pensó era obsoleta, pero en realidad valía miles de dólares

El equipo gratuito escondía hardware potente como una NVIDIA GeForce RTX 3090 y un procesador Intel Core i9-10850K

La primera computadora cuántica en universidades argentinas: así se capacita el talento para la próxima revolución tecnológica

Un equipo instalado en la Universidad Nacional de Hurlingham permite que estudiantes y científicos accedan a la vanguardia global

Todas las alternativas seguras para reemplazar a las memorias USB en 2026

La adopción masiva del conector USB tipo C y la superioridad de los SSD externos han limitado el pendrive a tareas técnicas, empujando a los usuarios hacia soluciones más rápidas

Crean el mapa 3D más grande del universo y revela cómo se formó el cosmos

El proyecto HETDEX logra reconstruir la estructura del cosmos de hace 11.000 millones de años, permitiendo visualizar cómo se agruparon las primeras galaxias

Apple lanza iOS 26.4 beta: todas las novedades que llegan al iPhone

La actualización para teléfonos y iPad añade nuevos emojis, cambios en la personalización y mejoras en la seguridad de la información